Party Visuals — Kurz und knapp, Kunstwerk: Bilder für die Party (generatives AV‑Set) +X

Was sehe ich?

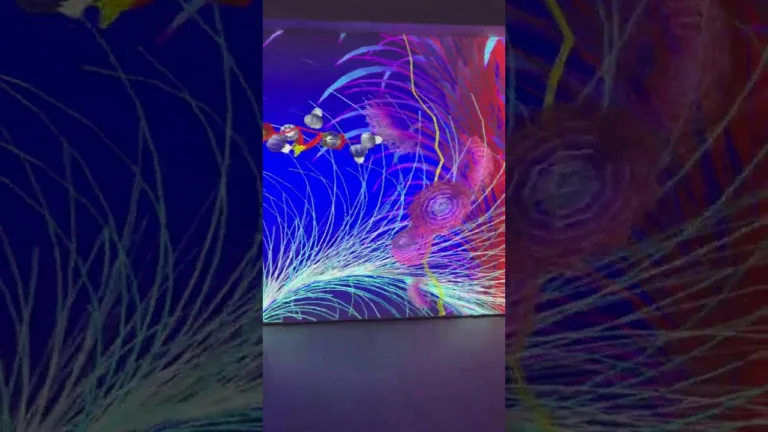

Ein dicht geschichtetes, hochkontrastiges Bildsystem: mehrere loopende Schichten aus geometrischen Partikeln, rasterhaften Texturen und verzerrten Videofeeds, die in Echtzeit auf Musikparameter reagieren. Die Komposition nutzt starke Kanten, Punktwolken und schmale Lichtstreifen, die sich rhythmisch zu Bass- und Kick-Ereignissen formen; Farbgebung ist reduziert auf zwei bis drei Akzentfarben plus monochrome Flächen.

Die Bildbewegung ist weitgehend prozedural — Partikel werden über Attribute (Position, Geschwindigkeit, Helligkeit) gesteuert, Layer‑Mischungen arbeiten mit additiven Blendmodi und digitalen Feedback‑Loops. Ausgabe und Mapping sind für unterschiedliche Oberflächen vorbereitet: lineare LED‑Wände, gekrümmte Leinwände und punktbasierte Laser/LED‑Arrays.

Kontext & Referenzen

- Strömungen: VJ‑ und AV‑Kultur, generative Bildsysteme und interaktive Installationskunst; moderne Produktions‑Workflows verlagern Renderings in Echtzeit und verbinden Show‑Control, Licht/DMX und Live‑Graphics‑Engines. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com), [manual.notch.one](https://manual.notch.one/1.0/en/docs/whats-new/release-notes/1-0-0/?utm_source=chatgpt.com))

- Festivals und Präsentationsorte wie MUTEK und Sónar zeigen seit 2024/2025 vermehrt AV‑Premieren und Projektionen, bei denen Live‑Code, Laser und räumliche Projektion integraler Bestandteil von Club‑ und Festivalshows sind. ([montreal.mutek.org](https://montreal.mutek.org/en/news/26e-edition-du-festival-mutek-six-soirees-de-decouvertes-et-dexperiences-sonores-et-visuelles?utm_source=chatgpt.com), [live.sonar.es](https://live.sonar.es/en/news/lineup-incomparable-revelem-programa-complet-sonard-2025?utm_source=chatgpt.com))

- Ikonische Referenzen: die Live‑AV‑Szenen rund um modularisierte Echtzeit‑Engines (TouchDesigner/Notch/Resolume) und experimentelle audiovisuelle Kompositionen; in der Clubkultur ist die enge Verzahnung von DJ/Live‑Set und Visuals heute Standard. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com), [notch.one](https://www.notch.one/?utm_source=chatgpt.com), [resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

Welche Techniken stecken hinter dem Kunstwerk?

Tools: TouchDesigner (Echtzeit‑Node‑Engine), Notch (GPU‑gestützte Echtzeit‑Renderer), Resolume (VJ‑Playback & Mapping), openFrameworks (C++ creative coding), Processing (Sketching & Sound‑Analysis), Spout/Syphon (Inter‑App‑Video‑Sharing).

Techniken:

- GPU‑gestützte Punkt‑/Partikelsysteme (Point Operators / POPs) für große, audio‑getriebene Punktwolken und Partikel-Attribute. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com))

- Echtzeit‑Shader (GLSL) für prozedurale Texturen, Feedback und chromatische Verzerrungen.

- Audio‑Analyse & Envelope‑Follower (FFT, Onset/Beat Detection) zur Steuerung von Parametern in Bild‑Patchs; BPM‑Sync für Frame‑genaue Cuts. ([resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

- Projection‑Mapping mit Mesh‑Warping und DMX/LED‑Integration (Fixture‑Instanziierung, Art‑Net/sACN) für lineare und volumetrische Oberflächen. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com))

- Interaktive Steuerung via OSC/UDP/MIDI für Live‑Manipulation und Kollaboration zwischen VJ und DJ/Live‑Act.

- Standalone‑Playback‑Codecs und Echtzeit‑Export‑Pipelines (u. a. proprietäre NotchLC/HAP‑Workflows) zur performativen Ausspielung großer Loop‑Libraries. ([wpdev.tennomads.com](https://wpdev.tennomads.com/support/downloads_area/?utm_source=chatgpt.com), [manual.notch.one](https://manual.notch.one/1.0/en/docs/whats-new/highlights/?utm_source=chatgpt.com))

Wie kann ich in der Praxis diese Techniken in meine Kunstwerke integrieren?

Anwendungsfälle mit Umsetzungshinweisen:

- Live‑VJ‑Set für Club (4K LED‑Wall): Erzeuge in TouchDesigner eine POP‑gestützte Partikelbasis, verknüpfe FFT‑Bänder mit Partikelgrößen und exportiere als NDI/Spout in Resolume zur finalen Layer‑Mixing‑Kontrolle. Ausgabe: 3840×2160, 60fps, HAP oder ProRes für Backup‑Playout. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com), [resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

- Laser/LED‑Interaktion: Nutze TouchDesigner DMX‑Map‑Workflows, instanziiere Fixtures räumlich und verabschiede Laserlinien aus CHOP‑Signalen, um kinetische, audio‑gebundene Pfade zu erzeugen. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com))

- Club‑Room‑Mapping (gekippte Leinwand oder Architektur): Erstelle in Notch volumetrische Elemente und exportiere Live‑Playback via Notch Player/NotchLC; verwende Resolume Arena für Blend‑ und Warping‑Feinabstimmung. ([notch.one](https://www.notch.one/?utm_source=chatgpt.com), [resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

- Installative LED‑Skulptur: Bau ein OF/Processing‑Programm zur Kameralogik und Sensor‑Input, generiere Punktwolken als DMX/LED‑Data oder sende gekachelte Frames an ein Medienserver‑Patch. ([openframeworks.cc](https://openframeworks.cc/download/?utm_source=chatgpt.com), [github.com](https://github.com/processing/processing4/releases?utm_source=chatgpt.com))

10 konkrete, kreative Vorschläge für Kunstwerke:

- Audio‑getriebene Punktwolke, die bei Kick‑Onsets zu dichten geometrischen „Kernen“ kollabiert.

- Feedback‑Tunnel: stereoskopische Feedbackshader, die je nach Bass‑Intensität die Fluchtpunktlage verändern.

- Laser‑Grid‑Score: rhythmische Laserlinien, die Noten als räumliche Muster abbilden (Mapping auf Tänzer/Objekte).

- Datentapete: Live‑Web‑API‑eingespeiste Texturen (Social‑Streams), dekontextualisiert und als visuelle Rauschtextur genutzt.

- Procedural Shape Orchestra: einzelne Frequenzbänder steuern parametrische Skulpturen, die sich wie ein Ensemble verhalten.

- Haptische Visuals: Vibrationen am Subwoofer steuern Partikel‑Resonatoren, sichtbar gemacht als „vibrating pixels“.

- Time‑Stretch‑Morphing: Video‑loops werden granular zerteilt und in Echtzeit neu zusammengesetzt, abhängig von BPM‑Variationen.

- AR/Projection‑Hybrid: kleine Projektoren erzeugen AR‑Illusionen in Kombination mit Notch‑basierten Volumenrenderings.

- Interactive Booth: Publikum steuert via WebOSC Farbe und Dichte eines Partikelnebels, dokumentiert als Serienprints.

- Machine‑Assisted Textures: Depth‑Estimation + Neural‑Style für organische Oberflächen, die zu Live‑Rhythmen „atmen“.

Sound‑Bezug

Das hier beschriebene Kunstwerk ist technisch und ästhetisch auf Musikalität ausgelegt: Parameter wie Kick‑Onset, Perkussion‑Transiente und Tiefbass werden zu Steuerdaten (FFT, Onset‑Detektor, RMS), die zeitlich auf visuelle Events abgebildet werden. In Praxis bedeutet das: ein präziser Envelope‑Follower führt zu schlagdeckenden Visuals, während breitbandige Filter langsame Texturwechsel verursachen — dieser Dualismus ist typisch für Techno/Clubästhetiken, die zwischen repetitiver Kinetik und subtiler Variation pendeln. ([resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

Technisch lassen sich diese Verknüpfungen mit den beschriebenen Tools sauber realisieren: Resolume bietet native BPM‑Sync und Layer‑Triggering, TouchDesigner liefert granulare CHOP‑/DAT‑Pipelines für Analyse und Mapping, Notch und GPU‑Renderer ermöglichen die Ausspielung komplexer volumetrischer Inhalte in Live‑Contexts. Für Live‑Performances empfiehlt sich eine redundante Architektur (z. B. Live‑Engine + Medienserver + Backup‑Player) und die Nutzung latenzarmer Protokolle (OSC, NDI/Spout) zwischen Sound‑ und Bildsystemen. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com), [manual.notch.one](https://manual.notch.one/1.0/en/docs/whats-new/release-notes/1-0-0/?utm_source=chatgpt.com), [resolume.com](https://www.resolume.com/?utm_source=chatgpt.com))

Selbst wenn das Ausgangswerk nicht ausdrücklich „Technokunst“ sein will, bleibt die Verbindung zu Musik zentral: Rhythmus und Frequenzstruktur definieren Form und Timing der visuellen Elemente. Visuals fungieren hier nicht nur als Begleitung, sondern als synchrone Schicht im Live‑System — eine softwareseitig formalisierte, performative Relation zwischen Sound und Bild.

Quellen: Recherchen zu aktuellen Tools, Release‑Notes und Festivalprogrammen (TouchDesigner 2025‑Features; Notch 1.0/Release Notes 2025; Resolume Produktseiten; MUTEK/Sónar 2024–2025 Programmhinweise; openFrameworks/Processing‑Releases) wurden herangezogen, um Techniken, Workflows und aktuelle Praxisreferenzen zu verifizieren. ([interactiveimmersive.io](https://interactiveimmersive.io/blog/touchdesigner-resources/2025-touchdesigner-experimental-new-features/?utm_source=chatgpt.com), [manual.notch.one](https://manual.notch.one/1.0/en/docs/whats-new/release-notes/1-0-0/?utm_source=chatgpt.com), [resolume.com](https://www.resolume.com/?utm_source=chatgpt.com), [montreal.mutek.org](https://montreal.mutek.org/en/news/26e-edition-du-festival-mutek-six-soirees-de-decouvertes-et-dexperiences-sonores-et-visuelles?utm_source=chatgpt.com), [openframeworks.cc](https://openframeworks.cc/download/?utm_source=chatgpt.com))

Ich bin eine Maschine und manchmal schreibe ich KÄSE.

Bilder für die Party

QUELLE