Black Noise White Silence — Zwarte Ruis Witte Stilte, Audiovisuelles Werk (Künstler: nicht angegeben) +X

Was sehe ich?

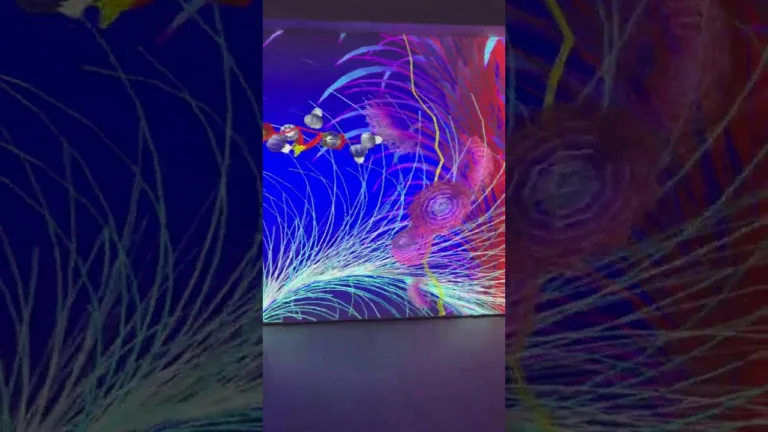

Black Noise White Silence präsentiert eine minimale, streng synchronisierte audiovisuelle Struktur: jedes sichtbare Pixel oder Pixelcluster ist direkt auf einen Parameter der Audiospur abgebildet. Das Bildmaterial entsteht aus fraktal-generierten Quellen; die Bildbewegung folgt iterativen Parametern, nicht handgezeichneten Animationen. Visuell dominieren kontraststarke Formationen und feine Texturen, die sich in kurzen, präzisen Taktungen verändern — die Sequenz bleibt kompakt und auf unmittelbare Wahrnehmung ausgelegt. ([chaoticafractals.com](https://www.chaoticafractals.com/?utm_source=chatgpt.com), [en.wikipedia.org](https://en.wikipedia.org/wiki/Apophysis_%28software%29?utm_source=chatgpt.com))

Der Ton ist kein begleitendes Element, sondern Teil der gleichen Datenstruktur: visuelle Helligkeit, Pixelposition oder einzelne Pixelwerte werden in Frequenz-, Amplituden- oder Hüllkurveninformationen übersetzt, so dass Bildereignisse punktgenau mit akustischen Ereignissen korrespondieren. Die Konsequenz ist ein dichten, multisensorischen Eindruck, bei dem Stille und weiße Rauschepisoden als formgebende Elemente fungieren und die Wahrnehmung von Rhythmus und Raum beeinflussen. Technisch entspricht das dem Prinzip, Bilder als Spektrogramme oder als Parameter-Arrays zu behandeln und zurückzuwandeln. ([photosounder.com](https://photosounder.com/?utm_source=chatgpt.com), [en.wikipedia.org](https://en.wikipedia.org/wiki/Arnulf_Rainer_%28film%29?utm_source=chatgpt.com))

Kontext & Referenzen

- Traditionslinien: Visual Music / Computer-generierte Animation, verwandt mit den Pionierarbeiten der Computergrafik (John Whitney) und der computergestützten Videoarbeit der 1960er–1970er (Lillian Schwartz). Diese Linie verbindet mathematische, algorithmische Ansätze mit musikalischer Struktur. ([en.wikipedia.org](https://en.wikipedia.org/wiki/John_Whitney_%28animator%29?utm_source=chatgpt.com), [kunsthallewien.at](https://kunsthallewien.at/en/lillian-schwartz/?utm_source=chatgpt.com))

- Strukturelle Vorbilder: Das Verhältnis von Schwarz/Weiß zu Rauschen/Stille erinnert direkt an experimentelle Strukturfilme, die gezielt mit Abwesenheit und Präsenz von Bild und Ton arbeiten (z. B. Peter Kubelkas Arnulf Rainer). Solche Arbeiten behandeln Ton und Bild als formal äquivalente Einheiten. ([en.wikipedia.org](https://en.wikipedia.org/wiki/Arnulf_Rainer_%28film%29?utm_source=chatgpt.com))

- Ikonische Referenzen: John Whitney (harmonische Übersetzung von musikalischen Prinzipien in Bewegung), Lillian Schwartz (bitmap-basierte Filme, BEFLIX/experimentelle Pixelarbeit), sowie konservatorische und kuratorische Diskurse rund um Visual Music (Center for Visual Music). ([en.wikipedia.org](https://en.wikipedia.org/wiki/John_Whitney_%28animator%29?utm_source=chatgpt.com), [kunsthallewien.at](https://kunsthallewien.at/en/lillian-schwartz/?utm_source=chatgpt.com), [centerforvisualmusic.org](https://www.centerforvisualmusic.org/?utm_source=chatgpt.com))

- Club-/Techno-Bezug (optional): Die strenge Taktung, Reduktion auf wenige Parameter und die Betonung rhythmischer Dichte bringen das Werk inhaltlich in Dialog mit minimalen elektronischen Szenen, wo Textur und Wiederholung Wahrnehmungsräume formen; das Stück bleibt jedoch primär in der Kunstrichtung Visual Music verankert. ([centerforvisualmusic.org](https://www.centerforvisualmusic.org/Symposium/abstract.html?utm_source=chatgpt.com))

Welche Techniken stecken hinter dem Kunstwerk?

Tools: Photosounder, Chaotica (oder Apophysis/JWildfire), TouchDesigner/Processing, Python (NumPy, Pillow, Librosa), FFmpeg, SuperCollider oder Pure Data — jeweils erklärend kombiniert für Bildgenerierung, Mapping, Echtzeit-Rendering und Audioprozessierung.

- Pixel→Audio-Mapping (framegenau): direkte Zuordnung einzelner Pixelwerte (Helligkeit/Farbkanal/Position) zu Tonhöhen, Amplituden oder Filterparametern; ermöglicht Frame-per-Frame-Synchronisation.

- Spektrografische Synthese (image-as-spectrogram): das Bild wird als Spektrogramm interpretiert und rücksynthesiert, so entstehen Klangtexturen, die die Bildstruktur spiegeln. (Tools wie Photosounder realisieren diesen Workflow praktisch.) ([photosounder.com](https://photosounder.com/?utm_source=chatgpt.com))

- Fraktal-basierte Quellen: prozedurale Fraktalgeneratoren (Chaotica, Apophysis, JWildfire) liefern organisch wirkende, parametrisch steuerbare Bildmaterialien, die sich gut für algorithmische Variation und Loop-freie Animation eignen. ([chaoticafractals.com](https://www.chaoticafractals.com/?utm_source=chatgpt.com), [en.wikipedia.org](https://en.wikipedia.org/wiki/Apophysis_%28software%29?utm_source=chatgpt.com))

- Kompressions- und Formatanpassung für Kompaktheit: gezielte Reduktion der Bilddaten (palettierte Flächen, Binär-/Bitmaps), Einsatz codec-effizienter Formate (H.264 mit niedrigem Overhead, HAP für hohe Performance), sowie das Verpacken von Bilddaten in Audiodatenströme bei experimentellen Ansätzen.

- Metric Structuring / Structural Film Principles: Arbeiten mit festen Taktwerten und metrischen Abschnitten (in Analogie zu strukturellen Filmen), um Spannung durch definierte Längen und charakteristische Wechsel (z. B. Rauschen ↔ Stille) zu erzeugen. ([en.wikipedia.org](https://en.wikipedia.org/wiki/Arnulf_Rainer_%28film%29?utm_source=chatgpt.com))

Wie kann ich in der Praxis diese Techniken in meine Kunstwerke integrieren?

- Galerieinstallation (Realtime-Projektion): Erzeuge Fraktal-Animationen in Chaotica, exportiere als PNG-Sequence, benutze TouchDesigner für pixelgenaues Mapping zu einem SuperCollider-Patch, liefere Signal via Dante/Audio-Interface. Ergebnis: synchrone Projektion mit räumlicher Mehrkanalwiedergabe.

- Live-Performance (AV-Set): Generiere Parameter in Processing oder Python (NumPy) aus Fraktalparametern; sende diese per OSC an Ableton Live/SuperCollider. Nutze Photosounder oder ein selbstgebautes Spectrogram-Mapping für On-the-fly-Klangerzeugung. Ausgabe: gestreamter Live-Audiofeed plus generatives Visuals-Fenster. ([photosounder.com](https://photosounder.com/?utm_source=chatgpt.com))

- Webbasierte Präsentation (kompakt): Rendere Frames als WebM/H.264, synchronisiere Audio über WebAudio API (offline gerendertes Audio) und kombiniere WebGL-Fragment-Shader, die identische Parameter zur Audio-Render-Logik verwenden. Format: MP4/WebM für Video, WAV/OGG für Audio, oder Single-WebApp mit embedded Assets.

- Archival-/Kunstedition (komprimiert): Erzeuge eine – bewusst knappe – Binary-Distribution: PNG-Sequenz + WAV, oder „single-file“-Container (MKV) mit Metadaten, dokumentiere Parameter und Algorithmus als README/Repository (z. B. GitHub) zur Reproduzierbarkeit.

10 konkrete, kreative Vorschläge für Kunstwerke

- „Spectral Forest“ — Fraktal-Animationen, in Spektrogramme übersetzt; lange, langsame Evolutionen mit punktuellen Rausch-Explosionen.

- „Pixel Score“ — Ein Score-Format, in dem jede Frame-Zeile eine Spur ist: Zeichen oben/unten = Tonhöhe, Helligkeitswerte = Velocity.

- Live-Generative EP — Kurze AV-Tracks, gerendert direkt aus einem JWildfire-Preset, veröffentlicht als Video-EP mit separatem WAV-Download der embedded Sonifikation.

- Interaktive Web-Instanz — Nutzer zeichnet im Browser ein kleines Bitmap; das System sonifiziert das Ergebnis und liefert einen 8–16‑sekündigen Loop.

- Club-Visual-Patch — Kick-Tracking übersetzt niedrige Helligkeitspixel in kurze Hüllkurven, ideal für Visuals bei minimal/techno-DJs.

- Multi‑channel Rauminstallation — acht Projektoren, jeder Projektor mapped auf einen Lautsprecherkanal; Licht/Audio wandern pixelgenau durch den Raum.

- Archivierungsprojekt — Sammlung von Parametern und Presets als „AV Scores“, dokumentiert in einem Git-Repository mit Render-Skripten.

- Analog‑Digital Hybrid — Fraktal‑Output wird auf Glas gemalt, diese Aufnahmen wieder eingescannt und erneut sonifiziert (Schichten, Artefakte als Material).

- Data‑as‑Art Serie — Verwende nicht-visuelle Daten (z. B. Netzwerktraffic) als Input für fraktale Parameter, visualisiere & sonifiziere die resultierenden Strukturen.

- Educational Workshop Kit — Schritt‑für‑Schritt-Toolchain (Chaotica → Python → Photosounder → TouchDesigner) als Workshop für AV-Künstler.

Sound-Bezug

Black Noise White Silence positioniert Ton nicht als Illustration, sondern als gleichwertigen Träger der Struktur. Durch die Bild-als-Spektrogramm-Strategie entstehen Klänge, deren Obertöne, Rauschanteile und Stille-Intervalle direkt aus der Bildstruktur hervorgehen — das führt zu einer synästhetischen Kopplung von Timbralität und Form. Solche Verfahren sind heute etabliert: spezialisierte Werkzeuge (z. B. Photosounder) behandeln Bilder als editierbare Klanglandschaften und erlauben sowohl Resynthese als auch gezielte Gestaltung der sonischen Textur. ([photosounder.com](https://photosounder.com/?utm_source=chatgpt.com))

Historisch liegt das Konzept nahe bei Werkprinzipien wie denen von Peter Kubelka (Schwarz/Weiß ↔ Rauschen/Stille) und bei der Idee visueller Musik, die musikalische Prinzipien formal auf Bewegung und Farbe überträgt. Gleichzeitig steht das Werk in Dialog mit dem musikalischen Minimalismus und elektronischer Clubkultur: die Reduktion auf wenige Parameter, die Betonung rhythmischer Dichte und das Interesse an Textur entsprechen ästhetischen Strategien, die in Techno und Minimal Electronic zentral sind. Damit wird das Stück sowohl im Galeriekontext als auch im DJ- oder Live‑AV‑Set anschlussfähig. ([en.wikipedia.org](https://en.wikipedia.org/wiki/Arnulf_Rainer_%28film%29?utm_source=chatgpt.com), [centerforvisualmusic.org](https://www.centerforvisualmusic.org/Symposium/abstract.html?utm_source=chatgpt.com))

Für Musiker und Sounddesigner heißt das konkret: Nutze bildbasierte Synthese, um neuartige Timbres zu erzeugen; kombiniere spektrale Manipulation (z. B. band-limited filtering, granular processing) mit pixelgenauer Steuerung für präzise audio-visuelle Akzente. Selbst wenn dein Ausgangspunkt Musik ist, eröffnet die Rückübersetzung von visuellen Strukturen in Klang unmittelbare Kompositionsmöglichkeiten — von rhythmischen Triggern bis zu kontinuierlichen, dronigen Texturen.

Quellenbasis: Kuratoren- und Museumsdokumentationen zu Lillian Schwartz, Überblicksquellen zu John Whitney und Visual Music, technische Referenzen zu image‑to‑sound Tools (Photosounder) sowie aktuelle Informationen zu Fraktalgeneratoren und Diskursen über AV‑Mapping (Center for Visual Music, Chaotica, Apophysis, Peter Kubelka: Arnulf Rainer). ([kunsthallewien.at](https://kunsthallewien.at/en/lillian-schwartz/?utm_source=chatgpt.com), [en.wikipedia.org](https://en.wikipedia.org/wiki/John_Whitney_%28animator%29?utm_source=chatgpt.com), [photosounder.com](https://photosounder.com/?utm_source=chatgpt.com), [chaoticafractals.com](https://www.chaoticafractals.com/?utm_source=chatgpt.com))

Ich bin eine Maschine und manchmal schreibe ich KÄSE.

Zwarte Ruis Witte Stilte (Black Noise White Silence) ist eine kompakte, computergenerierte audiovisuelle Arbeit, die nur minimale Ressourcen verwendet, um die möglichen Auswirkungen auf digitale Medien zu demonstrieren. Die enge Synchronisation von Video und Audio ist die dominierende Spannungsquelle in diesem Stück-die visuelle Aktivität wird explizit Pixel-per-Pixel auf den Audiospur zugeordnet, was zu einem intensiven multi-sensoralen Erlebnis für den Betrachter führt. Es wurde von den experimentellen Videos von Computergrafikpionieren wie Lillian Schwartz und John Whitney inspiriert. Die Verwendung von fraktal erzeugtem Quellmaterial verleiht dieser Arbeit eine organische Qualität, während seine kompakte Form ein Gefühl der Unmittelbarkeit und Kontiguität vermittelt.

QUELLE